آیا به دنبال نحوه رفع خطای «Blocked by robots.txt» در سرچ کنسول گوگل هستید؟ در ادامه این بخش از مقاله طراحی سایت شرکت توسعه رهاورد جرگه همراه ما باشید تا این مسئله رو به طور کامل بررسی کنیم. خطای «Blocked by robots.txt» در سرچ کنسول گوگل به معنای این هست که فایل robots.txt وبسایت شما ممکن هست به گونهای تنظیم شده باشه که به موتورهای جستجو دسترسی به برخی از صفحات و منابع وبسایت شما رو محدود کنه. این ممکن هست به دلیل تنظیمات نادرست در فایل robots.txt یا به دلیل وجود خطاهای دیگه در سرور شما اتفاق بیفته.

برای رفع این مشکل، ابتدا باید فایل robots.txt خودتون رو مورد بررسی دقیق قرار بدید. مطمئن بشید که در این فایل هیچ تنظیماتی وجود نداره که مانع از دسترسی موتورهای جستجو به صفحات مهم وبسایت شما بشه. بعد از اعمال تغییرات لازم، میتونید فایل robots.txt رو دوباره بررسی کرده و اطمینان حاصل کنید که همه صفحاتی که میخواید موتورهای جستجو اونها رو فهرست کنن، به درستی قابل دسترسی هستن.

همچنین، مطمئن بشید که سرور شما به درستی پاسخگو هست و هیچ مشکلی در ارتباط با موتورهای جستجو وجود نداره که مانع از دریافت درخواستهای اونها بشه. برای این کار، میتونید از ابزارها و سرویسهای آنلاینی مانند Google Search Console استفاده کنید تا وضعیت سرور و مشکلات مربوط به ارتباط با موتورهای جستجو رو بررسی کنید.

به طور کلی، برای رفع خطای “Blocked by robots.txt”، شما باید فایل robots.txt خودتون رو بررسی کرده و تنظیمات اون رو بهینه کنید و همچنین مطمئن بشید که سرور شما به درستی پاسخگو هست و هیچ مشکلی در ارتباط با موتورهای جستجو وجود نداره.

در این مقاله از سایت جرگه، نحوه رفع خطای «Blocked by robots.txt» رو به شما نشان خواهیم داد، همچنین توضیح خواهیم داد که این خطا به چه معناست و چگونه از تکرار اون در آینده جلوگیری کنید.

آنچه در این مقاله مطالعه میکنید :

خطای «Blocked by robots.txt» به چه معناست؟

خطای «Blocked by robots.txt» به این معنی ست که فایل robots.txt وب سایت شما، Googlebot رو از خزیدن در صفحه مسدود می کنه. به عبارت دیگر، گوگل تلاش می کنه به صفحه دسترسی پیدا کنه اما توسط فایل robots.txt مانع از اون می شه.

این ممکن هست به دلایل مختلفی اتفاق بیفته، اما رایج ترین دلیل این هست که فایل robots.txt به درستی پیکربندی نشده. به عنوان مثال، ممکن هست به طور تصادفی Googlebot رو از دسترسی به صفحه مسدود کرده باشید، یا ممکن هست دستورالعمل غیر مجاز رو در فایل robots.txt خود قرار داده باشید که از خزیدن Googlebot در صفحه جلوگیری می کنه.

چگونه خطای «Blocked by robots.txt» رو پیدا کنیم؟

خوشبختانه، پیدا کردن خطای «Blocked by robots.txt» بسیار آسان هست. برای یافتن این خطا میتونید از سرچ کنسول Google یا گزارش وضعیت فهرست در Rank Math’s Analytics استفاده کنید.

از سرچ کنسول گوگل برای یافتن خطا استفاده کنید!

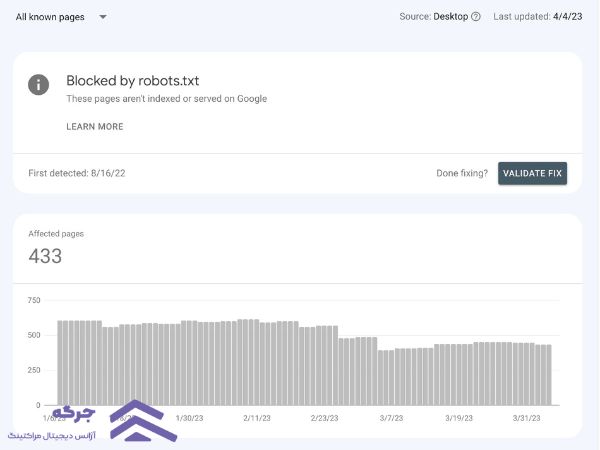

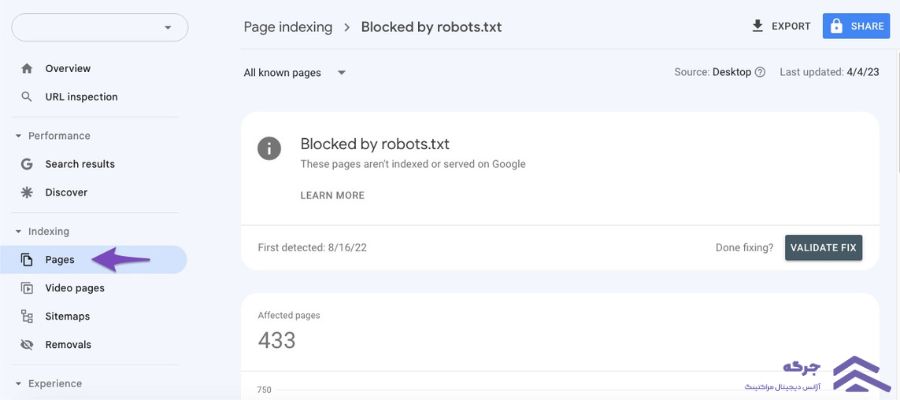

برای بررسی اینکه آیا این خطا رو در سرچ کنسول گوگل خود دارید یا خیر، کافی است به صفحه Pages رفته و بر روی بخش Not indexed کلیک کنید.

سپس مطابق شکل زیر بر روی خطای Blocked by robots.txt کلیک کنید:

اگه روی خطا کلیک کنید، لیستی از صفحاتی که توسط فایل robots.txt شما مسدود شده اند رو مشاهده خواهید کرد.

از تجزیه و تحلیل رنک مث برای شناسایی صفحات دارای مشکل استفاده کنید!

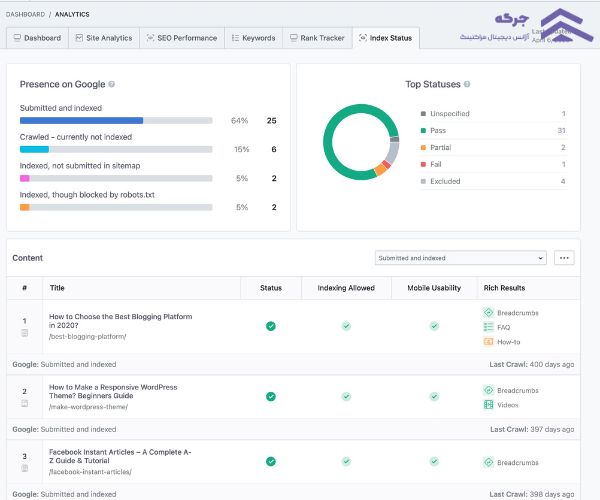

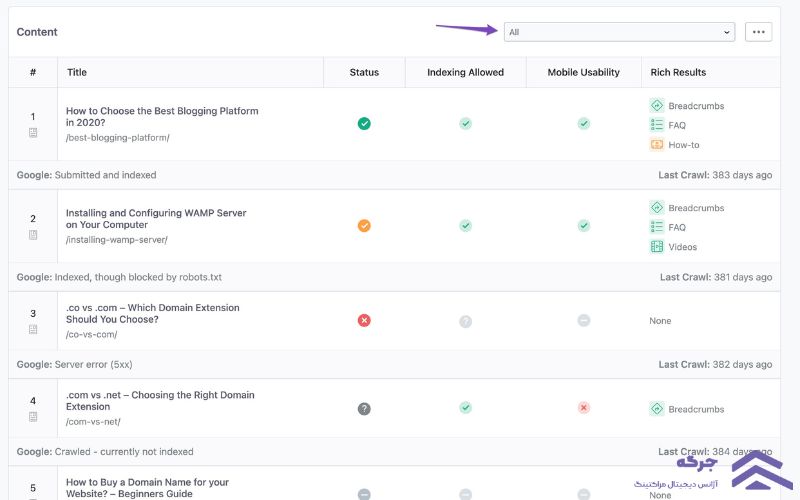

همچنین میتونید از گزارش وضعیت شاخص در Rank Math’s Analytics برای شناسایی صفحات دارای مشکل استفاده کنید.

برای انجام این کار، به قسمت Rank Math SEO → Analytics در داشبورد وردپرس برید. در مرحله بعد، روی تب Index Status کلیک کنید. در این برگه، data/status واقعی صفحات خود و همچنین حضور اونها در گوگل رو دریافت خواهید کرد.

علاوه بر این، می تونید وضعیت فهرست پست رو با استفاده از منوی کشویی فیلتر کنید. وقتی وضعیت خاصی رو انتخاب میکنید، بگویید «Blocked by robot.txt»، میتونید همه پستهایی رو ببینید که وضعیت فهرست یکسانی دارن.

پس از دریافت لیست صفحاتی که این وضعیت رو برمیگردونن، میتونید شروع به عیبیابی و رفع مشکل کنید.

نحوه رفع خطای «Blocked by robots.txt»

برای رفع این مشکل، باید مطمئن بشید که فایل robots.txt وب سایت شما به درستی پیکربندی شده. می تونید از ابزار تست robots.txt گوگل برای بررسی فایل خود استفاده کنید و مطمئن بشید که هیچ دستورالعملی وجود نداره که مانع از دسترسی Googlebot به سایت شما بشه.

اگه متوجه شدید که دستورالعملهایی در فایل robots.txt شما وجود داره که مانع از دسترسی Googlebot به سایت شما میشه، باید اونها رو حذف کنید یا یک مورد مجازتر جایگزین کنید.

بیایید ببینیم چگونه میتونید فایل robots.txt خود رو آزمایش کنید و مطمئن بشید که هیچ دستورالعملی وجود نداره که مانع از دسترسی Googlebot به سایت شما بشه.

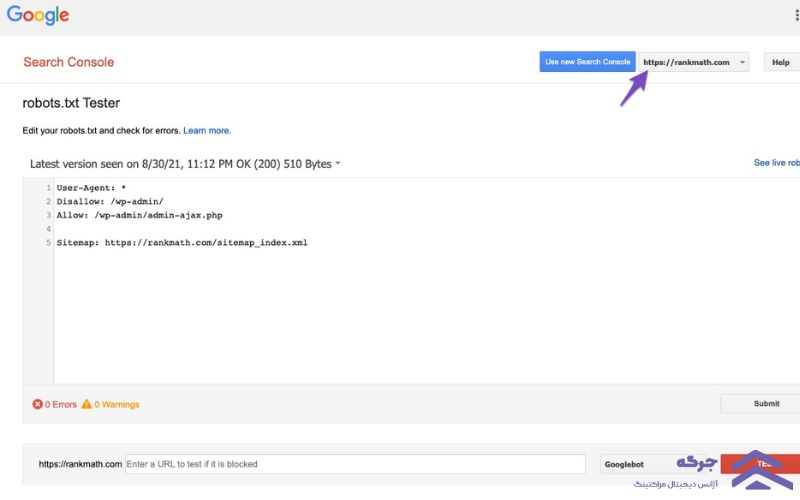

تستر robots.txt رو باز کنید!

ابتدا به تست robots.txt برید. اگه حساب Google Search Console شما با بیش از یک وب سایت مرتبط هست، وب سایت خودتون رو از لیست سایت هایی که در گوشه سمت راست بالا نشان داده شده، انتخاب کنید. اکنون گوگل فایل robots.txt وب سایت شما رو بارگیری می کنه.

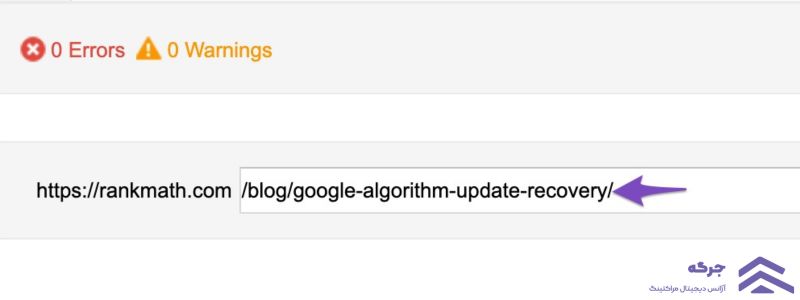

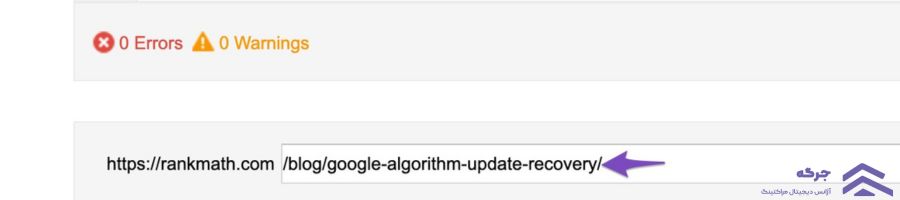

URL سایت خودتون رو وارد کنید

در پایین ابزار، گزینه ای برای وارد کردن یک URL از وب سایت خود برای تست پیدا خواهید کرد.

User-Agent رو انتخاب کنید

از منوی کشویی موجود در سمت راست کادر متن، عامل کاربری رو که می خواید شبیه سازی کنید (در مورد ما Googlebot) انتخاب کنید.

اعتبارسنجی Robots.txt

در نهایت روی دکمه Test کلیک کنید.

اگه به URL بر اساس پیکربندی robots.txt دسترسی داشته باشه، خزنده فوراً تأیید می کنه و بر این اساس دکمه آزمایش پذیرفته یا مسدود شده.

ویرایشگر کد موجود در مرکز صفحه همچنین قانون رو در robots.txt شما که دسترسی رو مسدود می کنه، همانطور که در زیر نشان داده شده، برجسته می کنه.

ویرایش و اشکال زدایی

اگه تستر robots.txt قوانینی رو پیدا کرد که از دسترسی جلوگیری میکنه، میتونید rule رو درست در داخل ویرایشگر کد ویرایش کنید و سپس یک بار دیگر آزمایش را اجرا کنید.

اگر rule رو اصلاح کردید، عالی هست. اما حتما توجه داشته باشید که این یک ابزار اشکالزدایی هست و هر تغییری که در اینجا ایجاد میکنید در robots.txt وبسایت شما منعکس نمیشه مگر اینکه محتوا رو در robots.txt وبسایت خود کپی و جایگذاری کنید.

خود رو ویرایش کنید Robots.txt Eith Rank Math

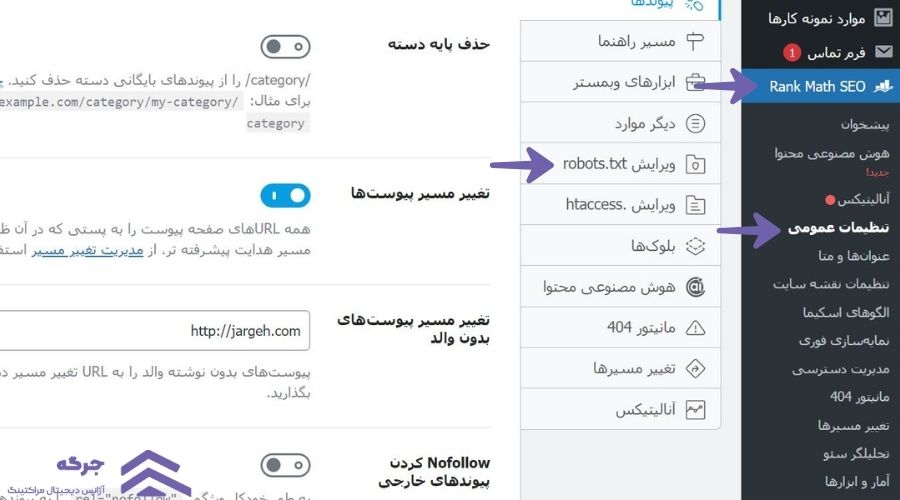

برای انجام این کار، به فایل robots.txt خود در Rank Math برید که در زیر WordPress Dashboard → Rank Math SEO → General Settings → Edit robots.txt مانند تصویر زیر قرار دارد:

توجه: اگه این گزینه برای شما در دسترس نیست، مطمئن بشید که از حالت پیشرفته در رنک مث استفاده می کنید.

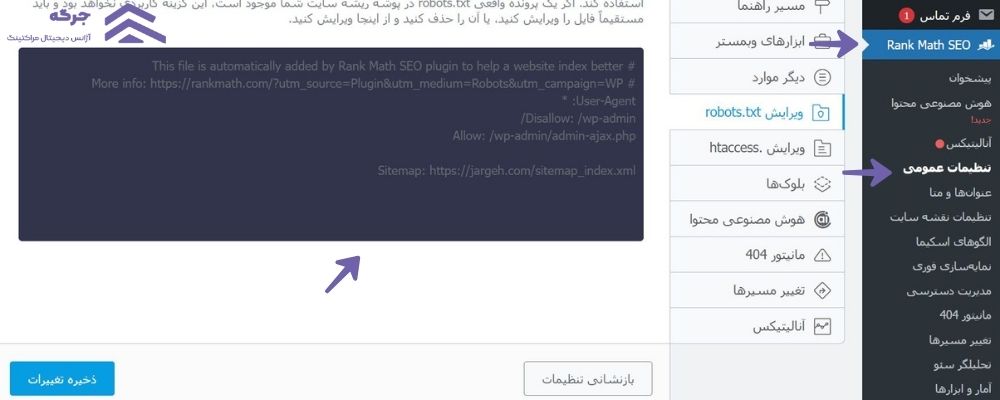

در ویرایشگر کدی که در وسط صفحه شما موجود هست، کدی رو که از robots.txt کپی کردید جایگذاری کنید. تست کنید و سپس روی دکمه Save Changes کلیک کنید تا تغییرات منعکس بشه.

لطفاً هنگام ایجاد هرگونه تغییر عمده یا جزئی در وب سایت خود از طریق robots.txt مراقب باشید. در حالی که این تغییرات میتونه ترافیک جستجوی شما رو بهبود بده، اما اگه مراقب نباشید میتونن آسیب بیشتری نسبت به سود داشته باشن.

برای توضیحات بیشتر، تصاویر زیر رو ببینید:

پس از انجام این تغییرات، گوگل میتونه به وبسایت شما دسترسی داشته باشه و خطای «Blocked by robots.txt» برطرف میشه.

چگونه از تکرار خطا جلوگیری کنیم؟

برای جلوگیری از تکرار خطای «Blocked by robots.txt» در آینده، توصیه می کنیم فایل robots.txt وب سایت خود رو به طور منظم مرور کنید. این کمک می کنه تا اطمینان حاصل شه که همه دستورالعمل ها دقیق هستن و هیچ صفحه ای به طور تصادفی توسط Googlebot خزیده نمیشه.

ما همچنین استفاده از ابزاری مانند Google’s Webmaster Tools رو برای کمک به مدیریت فایل robots.txt وب سایت خود توصیه می کنیم. Webmaster Tools به شما این امکان رو میده که به راحتی فایل robots.txt خود رو ویرایش و به روز کنید، همچنین صفحاتی رو برای فهرست بندی، مشاهده خطاهای خزیدن و موارد دیگر ارسال کنید.

سخن آخر

در پایان، امیدواریم این مقاله به شما کمک کرده باشه که چگونه رفع خطای «Blocked by robots.txt» در سرچ کنسول گوگل و در گزارش وضعیت Index Rank Maths analytics انجام بدید. هر سوالی در این زمینه دارید برای ما کامنت کنید …